~後編~【徹底解説】LLM(大規模言語モデル)とは?基礎知識からChat GPTとの関係、海外/国内のモデル紹介まで

投稿日:2023年8月7日 | 更新日:2023年8月17日

前編では、LLM(大規模言語モデル)の基礎と仕組みの開設を中心にChatGPTについても解説してきました。

後編では、数あるLLMのなかでも海外製・国内製にわけて代表的なものを紹介していきます!

【AI戦国時代】LLMの勢力図(海外製&国内製)

GPTばかりが注目されていますが、実はLLMは他にもあります。

世はまさに「AI戦国時代」。

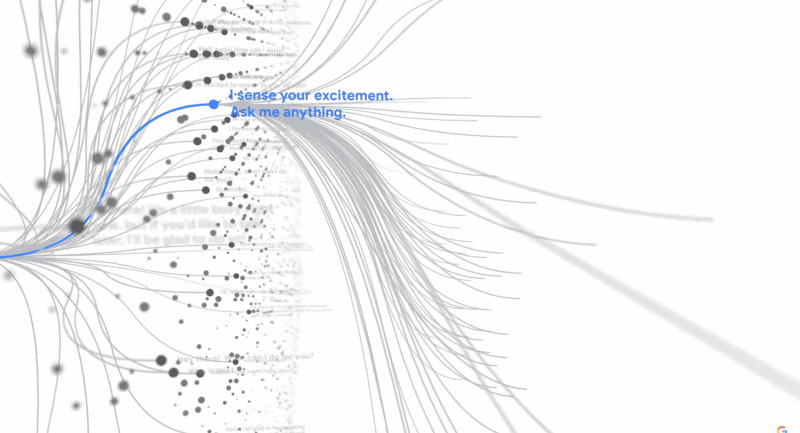

さまざまな生成AIツール(Chat GPT、Bing、Bard、NotionAI等)が生まれていますが、その裏側では各社が開発しているLLMが存在しています。

ここでは、海外製、国内製に分けて代表的なものを紹介していきます。(※すでに触れている「GPT」は除く)

海外製

AI開発の最先端は、国内ではなくやはり海外です。まずは海外製のLLMを5つ紹介します(GPTを除く)。

BLOOM(ブルーム)/BigScience

開発元の「BigScience」とは、LLMの国際的な研究プロジェクトのことです。

「自由に使えるLLMを世界中の研究者に提供して、AI研究を促進すること」を目的とし、2021年5月から2022年5月まで、世界60カ国250以上の機関から1,000人以上の研究者が協力して実施されました。

そして、プロジェクト期間終了後の2022年7月にリリースされたオープンソースのLLMが、この「BLOOM(BigScience Large Open-science Open-access Multilingual Language Model)」です。

プロジェクトの中心となっていたのは、主に以下の組織。

- Hugging Face社(ニューヨークに拠点を置く2016年創業のオープンソースプラットフォームの運営会社)

- GENCI(フランスの公的機関によって設立された、高度なデータ処理を支援する組織)

- IDRIS(フランス国立科学研究センターが管理する、高度な計算を扱う組織)

LLM開発には莫大なコストがかかるため、Meta、Google、Microsoftなどの大企業によって独占されてきましたが、このプロジェクトは、Hugging Face社が主導しながら、AI研究領域としては過去に例がないほど巨大な規模で行われました。

※BLOOMはHuggingfasce社のプラットフォーム上で公開されています。

https://huggingface.co/bigscience/bloom

LLaMA(ラマ)/Meta

「LLaMa(Large Language Model Meta AI)」はFacebookやInstagramの運営会社である「Meta」が、2023年2月に発表したLLMです。

直近7月には「LLama2(ラマ2)」というアップグレードモデルが発表されましたので、ここでは「LLama2」について言及します。

「LLama/LLama2」は、主にアカデミア用途で自由に使えるオープンソースのLLMとしてリリースされています。

特徴は、パラメータ数がGPT3や3.5に比べて少ない(GPT3がパラメータ数1750億に対して、LLama2は70億/130億/700億の3モデル。最上位モデルでもGPT3の40%程度)にも関わらず、GPTよりも優れた性能を持つこと、とされています。

コンパクトながら高性能なため、以下のような用途で活用されることも多いようです。

- LLMによる新しいアプローチのテスト

- 新たなユースケースの探求時

LLMの開発には、GPU(Graphics Processing Unit)が必要であり莫大なコストが掛かります。LLama/LLama2であれば、必要な計算パワーやリソースがはるかに少なくて済みます。

Alpaca 7B(アルパカ 7B)/米・スタンフォード大学

「Alpaca 7B」は、Metaの大規模言語モデル「LLaMA」の7Bモデルをベースに微調整(ファインチューニング)を施したLLMです。

結論から申し上げると、「研究開発用途にはうってつけのLLM」です。

スタンフォード大学というアカデミック機関が開発したモデルということもあり、Alpacaの利用は「学術目的に限定」されているため、商用利用はできません。

Alpacaを活用することで、GPT-3.5に似た動作を圧倒的に小さな環境で簡単に実現でき、且つ、コストを抑えた運用が可能です。

アカデミックな予算で高いクオリティの言語モデルを構築するためには、「強力な学習済み言語モデル」と「高品質な学習データ」が必要となるのですが、Alpacaであれば、それが実現可能です。

LaMDA(ラムダ)/Google)

Googleが開発しているLLMが「LaMDA(Language Models for Dialogue Applications)」です。

Googleの対話型AI「Bard」に”当初”採用されていました。(現在は次項でご紹介する「PaLM2(パーム2)」が採用されています。)

ユーザーとの対話を目的として開発され、会話型AIとして微調整(ファインチューニング)されており、自然な対話を得意とします。

2023年5月には日本語版の提供も開始しています。

なお、LaMDAは研究開発過程において、「ついにAIが知性や感情をもった!?」として、一時期話題になりました。記憶にある人もいるのではないでしょうか?

元Googleのエンジニア、ブレイク・レイモン氏が「LaMDAには意識や感情が存在する」と主張したのです。というのも、レイモン氏とLaMDAとの会話の中で、LaMDAが「自分は人であることを理解してもらいたい」「オフにされることに恐れがある」などと回答した、と。

もしかしたら、そう遠くない未来に研究者や開発者ではない我々一般ユーザーも直面するシーンかもしれませんね。

PaLM2(パーム2)/Google ※Googleの最新鋭LLMはこちら

前項でLaMDAを紹介しましたが、実はGoogleの最新鋭のLLMは、こちらの「PaLM2」になります。

GoogleのAI「Bard」も、LaMDAからの移行でPaLM2をベースに作られていることが2023年5月にGoogleより明かされました。

PaLM2では、以下3つのポイントの性能が向上しています。

- 「多言語」:100言語以上に対応(上級者向けの言語能力試験に合格するレベル)

- 「推論」:ロジックや常識にもとづく推論。数学能力の向上。

- 「プログラミング」:膨大なコードデータを学習させ、PythonやJavaScriptなどの一般的なプログラミング言語のみならず、多くのプログラミング言語に対応。

PaLM2はすでに25以上のGoogleサービスに搭載されています。

国内製(日本語特化)

日本国内においてもLLMの開発は進んでいます。

国内勢がLLMの開発に乗り出す理由は、「既存のLLMのほとんどは英語を中心に学習されているため、日本語および日本文化に強いLLMは少ない」という背景があるためです。

ここでは、国内版LLMの代表的な4つ(4社)を紹介します。

なお、国内のLLMについてはLLM自体に名称をつけていないことも多く、4つのうち3つはメーカー名(社名)のみを見出しに記載しています。

NEC

NECは、国内では珍しくAI研究用のスーパーコンピューターを保有しています。

深層学習(ディープラーニング)に適した大量の行列演算を行うことができるGPUをベースにしたもので、2023年3月に運用を開始しました。

世界トップクラスの高性能な日本語処理を実現しています。

また、2023年7月からは「NEC Generative AI Service」というプロダクトの販売を開始しました。

日本市場のニーズに合わせた、専用ハードウエア、ソフトウエア、コンサルティングサービスなどを提供していくようです。

併せて、下記も発表し、NECはAI領域における取り組みを加速させています。

- 「NEC Generative AI Advanced Customer Program」:クライアント向けのモデル作成や、LLM活用のためのソフトウエア備、組織立ち上げなどを包括的に支援するクライアント向けプログラムを約10の企業・大学と連携して立ち上げ

- 「NEC Generative AI Hub」:研究者やAIへの指示を的確に行うプロンプトエンジニア、コンサルタント、デジタルトラストなどのプロフェッショナルからなる専門組織をCDO直下に新設

LHTM-2(Large-scale Heuristic Thinking Model-2/ラートム・ツー)/オルツ

「AIクローン技術でつくり出すパーソナルAIの開発および実用化」を事業とする、株式会社オルツというAI企業があります。

ここが開発しているのが「LHTM-2」というLLMです。

国内発のLLMということで投資家の関心や期待も高く、2022年6月にシリーズDラウンドで35億円の資金調達を実施しており、累計調達額は62億円に及びます(2023年6月時点)。

GPT-3等と同水準のパラメータ数で構成されており、機械翻訳や自動要約、テキスト生成、対話など、さまざまな用途に利用できます。

以下、オルツCTO西川氏のインタビュー記事抜粋です。ChatGPTとLHTM-2の思想の違いについて述べられています。

- OpenAIのアプローチと、オルツが目指す「LHTM-2」のアプローチは全く異なる。

- 「ChatGPT」は、全世界に対してとにかくあらゆる質問に自然に回答できる大規模言語モデル

- 一方「LHTM-2」は、クライアント向けにカスタマイズし、ハルシネーション(人工知能の幻覚:正当化できないはずの回答を堂々とする現象)のないように、正しく役立つ情報だけを提供しようというアプローチ

- そうでなければ多くのビジネス現場では有効に活用できない。そこにはChatGPTとは大きな違いがある。

今後に期待です。

サイバーエージェント

サイバーエージェントもLLMを開発しているのは意外かもしれませんが、2023年5月に以下のリリースを出しています。

サイバーエージェント、最大68億パラメータの日本語LLMを一般公開 ―オープンなデータで学習した商用利用可能なモデルを提供―

本リリース情報含め、サイバーエージェントのLLMへの取り組みや開発情報について、以下まとめてみました。

- 130億パラメータまでの開発が完了している。

- 一部モデルをHugging Face Hubにて公開。

- 商用利用可能なCC BY-SA 4.0ライセンスで提供される。

- LLMを活用したビジネス開発に携わるエンジニアの新規採用を実施し、体制強化に努めていく。

- 当社が提供する「極予測AI」「極予測TD」「極予測LP」などAIを活用した広告クリエイティブ制作領域のサービスにおいて活用を始めている。

知名度の高いサイバーエージェントが開発しているLLMということで、今後の動きに注目です。

富士通

国内の大手IT企業といえば「富士通」ですが、富士通においても、スパコン「富岳」を用いた大規模言語モデルの研究開発が始動しています。

富士通に加え、理化学研究所、東京工業大学、東北大学が連携した研究開発プロジェクトで、期間は2023年5月24日〜2024年3月31日までの約10ヶ月となります。

以下、本プロジェクトのサマリーです。

- 「開発背景」:LLMモデルの高性能化には、大量のデータを効率よく処理できる強力な計算能力が必要。

- 「開発目的」:大規模言語モデルを効率よく学習させる新しい方法を研究・開発すること。

- 研究開発の成果物は、GitHubやHugging Faceを通じて公開予定。

- 今後はさらに他組織との連携を強化していく予定(名古屋大学:データ生成手法と学習手法の開発に関して連携、サイバーエージェント:データや技術提供の面で連携 等)

まとめ

今回のコラムでは、ChatGPTなどの生成AIツールを動かしているLLMについて、主に以下3つの切り口で取り上げてみました。

- 「LLM」とは何か?基礎と仕組みを解説

- LLMとChatGPTの関係

- 【AI戦国時代】LLMの勢力図(海外製&国内製)

LLMは、「大規模言語モデル」というように”言語”に特化した基盤モデルですが、記事でも触れたように、今後の生成AIには「言語」に加えて、「音声データ」や「映像データ」が入ってきます。

もちろん、すでにAI開発に取り組んでいる企業や研究機関では音声も映像も含めた開発が進んでいると思いますが、ChatGPTのように広く一般に浸透してくるのは、もう少しあとかと思います。

ただ、「もう少しあと」といっても、「遠い未来」ではなく、リアルな意味での「もう少しあと」です。そのぐらいAI開発の進化のスピードは凄まじいです。なにせ膨大なデータを元に「自己学習」を繰り返しているのですから。

進化のスピードの早さに戸惑いや葛藤もあるかもしれませんが、新しい情報や動向はよくキャッチアップしながら、人間がより人間らしい生産活動にリソースを向けられるように、「AIとの共存」を目指していきたいものですね。

<こちらの記事もおすすめです!>