ディープラーニングと意味理解|松尾 豊 氏(東京大学大学院 工学系研究科 特任准教授)

Communicative AI Conference 2018 講演レポート

投稿日:2018年12月27日 | 更新日:2025年2月26日

人間を凌駕するAIの登場

囲碁の人工知能AlphaGo(アルファ碁)がプロ棋士に勝ったことが話題になった。昨年は柯潔(カケツ)9段に3勝0敗で勝利した。もはや人間には負けないレベルに達している。

その後も進化を遂げて、昨年の終わりにはAlpha Zeroが登場した。AlphaGoはプロ棋士との対戦、その後に自己対局の2つの方法で学習していたが、Alpha Zeroは最初から自己対決で学習する。したがって、将棋やチェスでも強くなれる。まったく将棋を学習していない状態から、わずか2時間で人間の名人を超えることができるAIなのである。

ディープラーニングついて、松尾氏は3つの流れで変化が起きると語った。

ディープラーニングでは、大きく分けて「認識」「運動の習熟」「言葉の意味理解」が順番に起こると考えています。4年ぐらい前からこの順番で進むことを言っていますが、ほぼこの通りにディープラーニングは進展してきました。

まず「認識」では、画像認識はここ数年で著しく向上した。ディープラーニングが登場以前の2011年には、画像認識のエラー率は25.7%だった。ところが2012年にディープラーニングの登場によって、16.4%と進歩を遂げた。その後、継続的にエラー率のスコアは下がり、現在は2.3%である。人間が同じタスクを行ったときのエラー率は5.1%。画像認識においてAIは人間が敵わないレベルに到達した。

映像に映っているものを読み取るオブジェクト・ディテクション(物体検出)では、映像からバウンディングボックスで切り取って、人間の顔を認識する。

YORO v2では1秒に50フレームの動画を認識し、映像をリアルタイムで読み取ることができます。さらにこのアプリケーションはインターネット上のGit Hubに公開されています。最新のものも出てきていますが、誰でも使えます。

次に「運動の習熟」では、画像認識と強化学習を組み合わせる。2015年にUCバークレーから出てきた研究が発端で、ロボットにいろいろな動作を学習させることができる。眼の部分にカメラがあり、繰り返すことで上達する。靴ベラを入れる、ペットボトルのフタを締める、ハンガーを掛ける、子どもが遊ぶブロックをはめる、ロボットアームでさまざまなものを上手に持ち上げる、などいろいろな動作が可能になった。

松尾氏は次々と映像を紹介しながら、次のように補足した。

今年の7月に発表されたものですが、人間の手のようなロボットで、サイコロの指示された面を右下に向けることもできるようになりました。人間には簡単ですが、物理計算でやろうとすると非常に難しいことです。

そして「言葉の意味理解」としては、2016年にGoogle翻訳がディープラーニングの方式に変わったことを指摘した。技術自体は2014年頃からあったが、非常に大規模なスケールだったため、精度が上がったのだという。

従来のGoogle翻訳のフレーズベースのスコアが、ニューラルネットワークを使って人間に近いレベルになりました。中国語から英語への機械翻訳は人間と同等のレベルに達したことを、Microsoftが論文を発表しています。

原理がシンプルで汎用性の高いディープラーニング

ディープラーニングとは何か。松尾氏は一言で定義した。

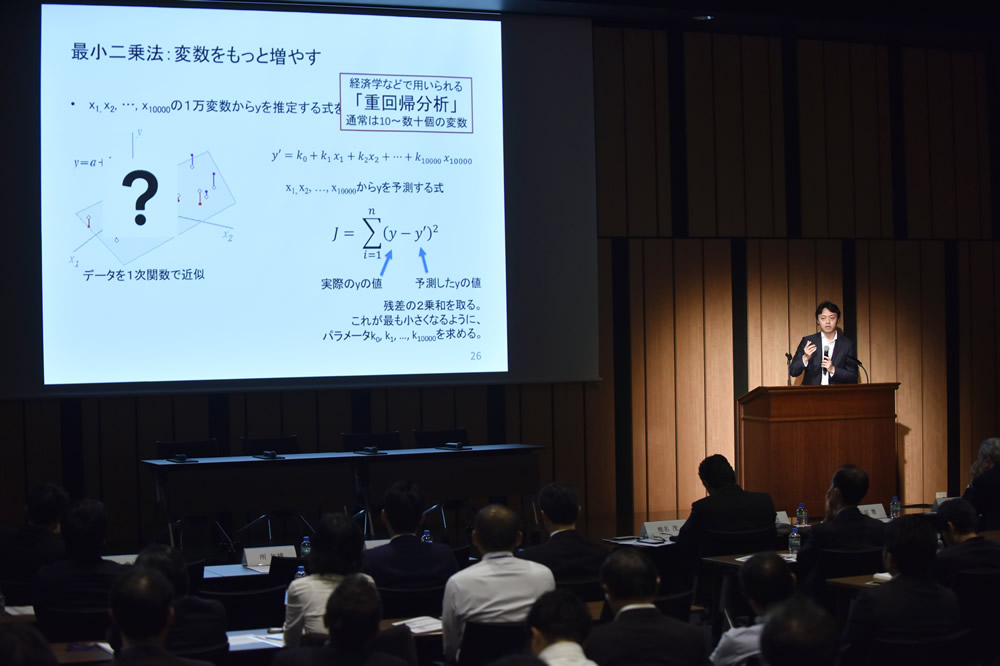

深い関数を使った「最小二乗法」です。変数の数が「多い」ことと「深い」ことが特長です。たとえば、ある飲料に売上と気温データがあったとき、このデータからExcelで散布図を作ります。近似直線の追加をすると直線が引けます。これが「最小二乗法」です。直線なのでy=a+bxの数式になりますが推定値です。そこで実際の値に対するズレを引き算して、正負を自乗します。この差を最小にするようにaとbのパラメータを決めると、直線上のきれいな線が描けます。

売上と気温に湿度のデータを加えると立体になり、直線は平面に変わります。いわゆる経済学やマーケティングで使われる「重回帰分析」です。これを1万の変数にしてみましょう。100×100ピクセルの画像を考えると、1万ピクセルです。猫であるときは「1」、猫ではないときは「0」を返す関数をみつけることで、最小二乗法で解くことができます。

人工知能が猫を認識する猫関数があったとすれば、その誤差を減らすようなパラメータを求める。したがって、ディープラーニングは、変数の数がめちゃめちゃ多い最小二乗法ということになりますね。

もうひとつ大切なことは「深い」ということだという。深くするためには、中間的な関数を定義をする。2層、3層、4層と中間関数の数を増やせば深くなると説明した。

料理の手間を増やせば、野菜を切るだけの作業から、いろんな料理ができるようになることと同じです。1回だけの条件の関数では制約が強くなります。何回も関数を使って出力の誤差を最小化させると、非常にバラエティに富んだ結果になります。関数を深くすることにより、いろんな入力と出力を非線形にできることがディープラーニングの本質です。

「深く」するにはいろいろなやり方があり、ディープラーニングには4つほどの系統があると松尾氏は説明した。

画像認識に非常に強い「CNN(Convolutional Neural Network)」、時系列の音声や言葉の処理に強い「RNN(Recurrent Neural Network)」、 画像を生成できる「深層生成モデル」、そしてロボットが学習できる「深層強化学習」もである。いずれにしろ深い関数の作り方にノウハウがあり、工夫を重ねていくことが重要だという。

最小二乗法ですから、XとYの関係をどうするのかという工夫がビジネスのすべて。Xを画像でYを猫にすると一般的な画像認識ですが、Xを顔画像にしてYを人の名前にすると顔認証の技術ができます。工夫次第なんです。

XとYを何にするか決めて、その間をつなぐ回路を決め、損失関数と呼ばれる誤差を最小化すべき関数を定め、損失関数を最小化するパラメータをみつける。それが完成すれば、新しいXが入ってきたときに自動的にYを出せるようになるのだという。したがって、医療診断の技術、翻訳などいろいろなことが可能だと述べた。

ディープラーニングは「原理がシンプルで汎用性が高い」ことが重要です。だからこそ、インターネットやトランジスタのように大きな変革をもたらす技術であると考えています。

インターネットではハイパーリンクが重要だった。リンクがつながることでページがつながり、Webサイトが検索エンジンに掲載されるようになり、eコマースやSNSができた。トランジスタの発明では、信号の増幅がポイントである。トランジスタを使ってラジオができ、パソコンが生まれた。いずれも原理は簡単で汎用性が高いことが特長で、ディープラーニングも同じだと説明した。

ところで、

人間は、8~9割の情報を眼から得ています。『眼の誕生』という本では、三葉虫が目を獲得した「カンブリア爆発」によって外界から身を守ったり、さまざまなものを認識したりするようになった「光スイッチ説」が述べられています。ディープラーニングも、眼の獲得によって大きく進化しました。

生物と同じような変化が、機械やロボットに必ず起こります。大きな変化としては、労働集約型の仕事が自動化されることです。農業では収穫や除草には、視覚が必要です。これまでロボットには眼がなかったから人間がやるしかなかったのですが、眼を獲得した機械により産業が変わります。農業に限らず、建設、食品加工、組み立て加工など、さまざまな領域でビジネスチャンスを生みます。

CEATEC(CPS/IoTの展示会)では、片付けロボットが展示されていました。家事労働においても、画像認識が必要とされています。今後はセンシングにより認識する家電がたくさん登場するのではないでしょうか。

医療や他の分野の需要もあるという。Arterys(米国のベンチャー企業)では心室内のMRI画像を分析しているが、今年の4月には糖尿病の眼底検査のような医療機器も登場した。医師が解釈しなくても自動で結果を出すことをFDAが承認している。また、1億7,000万台のCCTVカメラが設置されているといわれている中国では、顔認識が盛んである。誰がどこにいるか追跡できると紹介した。

イチゴの収穫ロボットや、カツ丼の盛り付け判定、泳ぐマグロを数えることなどといったところにもAIは活用されています。料理の盛り付け判定は、いろいろな飲食店で幅広くやっているので、そのようなビジネスチャンスは数多くあるのではないでしょうか

対話型AIは実現可能なのか

今回のカンファレンスのテーマでもある、対話型AIについても触れた。

AIとの対話は、そんなに単純ではないと考えています。原点からお話しますが、そもそも人間は頭がいいと言われていて、なぜ他の動物と違って頭がよいかといえば、言葉があるからです。人間だけが言葉を使います。

「言葉や数字などのシンボルが知能の根源なのか?」ということは、人工知能研究の初期から問われてきた。1960~1970年代には、知能の根源は「記号(シンボル)」という考えが一般的だったという。その主張をした代表者としてマービン・ミンスキー氏がいるが、それに対してルンバを作ったロドニー・ブルックス氏は「像はチェスをしない」と述べていると紹介した。こうして長い間「シンボル VS パターン」の論争が続いているのだという。

この論争に対して、松尾氏は次のように語った。

答えは非常に簡単だと思っていて、人間も言葉を除けば動物です。何かの情報を認識することで適応的に行動を決めています。この世界は完全にパターンの処理です。ところが人間は、動物的行動の上に記号の処理がある2階建て構造になっています。現在のディープラーニングは1階部分の「認識」「運動の習熟」に取り組んでいるところです。この1階部分が完成した後に、ほんとうの意味で言葉の理解や対話ができると考えています。

イヌは飼い主が倒れたときに助けに行くことがある。なぜそのようなことができるかといえば、思考の抽象度を上げられるからだと松尾氏は説明した。しかし、人間が優れているのは「抽象度の高い2階のレイヤーから動物的な1階のレイヤーを駆動できることだ」と語った。「大きなリンゴの木がありました」と聞くと、我われはそれを想像することができる。しかし、普通の動物は想像しない。想像することによって生存の危機が高まるからだという。

『サピエンス全史』でも語られていますが、虚構を信じることによって、人間は集団としての結束力を高め、生存確率を上げてきました。このように2階の抽象化機能から1階の運動機能を駆動することによって、たまたま人間は生存確率を高めたのでしょう。そして人間は2階の部分だけ勝手に動かせるようになり、その結果、物理学や数学など文明を生んだのでは。

これまでAIは2階部分だけが研究されてきた。次に1階部分が完成しつつあると松尾氏は述べた。この1階(認識・運動)と2階(記号)が完成することで、ほんとうの意味の人工知能が登場するということが松尾氏の見解である。

1階と2階が完成した世界に到達すれば、AIによる言語や対話が飛躍的に向上すると考えます。現在では想像できない世界がやってくるでしょう。どれぐらい先か分かりませんが、このまま技術が進めば5~10年後に達するのではないでしょうか。とても楽しみです

知能について、1950年には機械と人間を判別する「チューリングテスト」が注目された。人間と機械を判別できないなら、知能を持っていると考えてよいのではないか、という概念である。それに対してジョン・サールは「中国語の部屋」という概念を提示した。ある部屋に送られてくる文字を、非常に分厚い辞書を調べることで中国語に変換するイギリス人がいたとする。別の部屋からみると、賢い中国人がいるように見える。しかし、何も文章の意味を分かっていないので知能があるとは言えない、とサールは述べた。

私はチューリングとサールでは、サールが正しいと思います。なぜなら、認識・運動の1階部分を駆動しないで記号の2階部分だけを働かせていることは、ほんとうの意味で知能を持っているとは言えないからです。古くはチョムスキーが、文法的には正しいけれどナンセンスな言葉があることを指摘しています。

人工知能の研究には歴史があり、対話や言語処理に関していえば、いまの技術でも可能なことはたくさんある、と松尾氏は主張した。

そこで、シンプルかつパワフルな可能性を秘めたディープラーニングに精通して次世代を担う人材を育成するために、2015年から松尾氏は大学で次世代を育成してきた。受講者も増え、研究室からベンチャー企業も誕生している。松尾氏はこの動きを日本全国で展開したいと考え、昨年ディープラーニング協会を設立。「G検定」というディープラーニングの資格試験を実施している。既に、1,500~2,000名が受験したという。

意味を理解できるAIがそのうちできます。そのときすごいイノベーションが起きると信じています。

GAFA(Google、Amazon、Facebook、Apple)が強いとはいえ、日本も十分に闘っていけるようにしたい、と松尾氏は考える。