コンタクトセンターにおける音声認識や

感情分析の技術進化とコールでの活用のされ方

投稿日:2023年2月22日 | 更新日:2023年2月22日

顧客対応を行うオペレータ、電話やチャットで問い合わせを行う顧客。

課題解決に向けてポジティブだったコミュニケーションを振り返り、ネガティブだったコミュニケーションを改善するために、またはそれ以外の応用も含めてAIを用いた「感情分析」技術を応用するケースが増えてきています。今回のブログでは「感情分析」や「音声認識」の技術進化と現状 について整理してみたいと思います。

※ 関連する『VOC』については

をご参考ください。音声認識と感情分析のしくみ

まず「音声認識」技術とは、人の音声をデジタルデータに変換してから文章(テキスト)化する技術です。スマートスピーカーやボイスボットに使われている技術としても最近は活用されるシーンが増えてきていますが、AIの発展により音声の認識精度が向上してきました。とくに全体像から細部までの各々の概念を階層構造として関連させて学習する手法、ディープラーニングがAIにおいて発展したきたことも音声認識技術を進化させたと言えます。

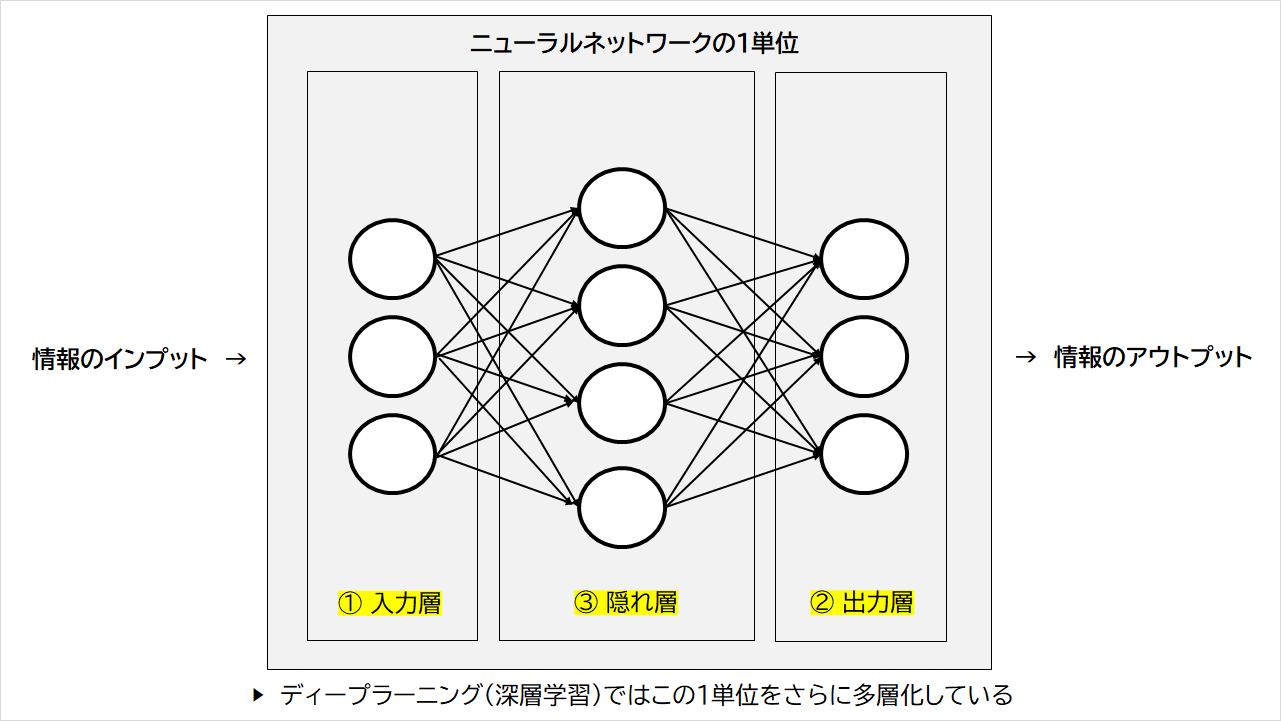

ディープラーニングは2000年代後半から進化してきましたが、人間の神経細胞(ニューロン)の仕組みを参考に作られたシステム「ニューラルネットワーク」がベースになっています。「ニューラルネットワーク」では①情報が入力される「入力層」、②情報が発信される「出力層」、③その中間にあって計算を行う「隠れ層」の3層で構成されるのが通常ですが、ディープラーニングではその日本語訳の「深層学習」の文字通りにこの3層単位のニューラルネットワーク=1単位として、それらがさらに多層的に積み重なることで、より複雑な計算・学習ができるようになっています。多層構造のニューラルネットワークに音声データをインプットすると、AIはデータに含まれる特徴をそれぞれの層で自動的に計算・学習していきます。

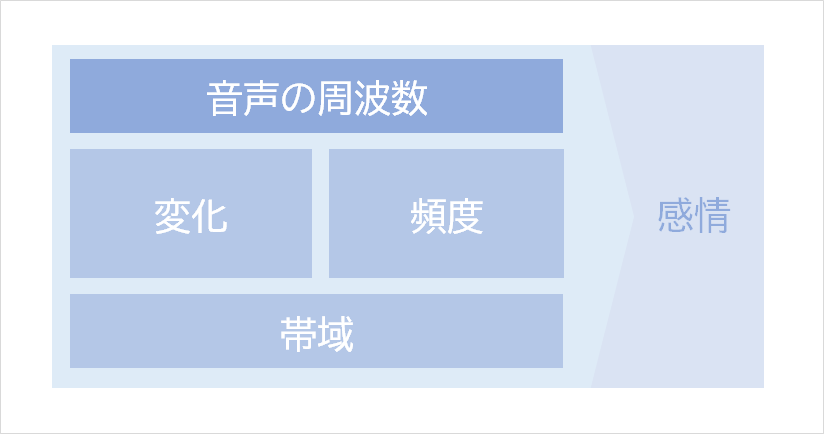

では何を計算・学習しているかというと、主に音声に含まれる周波数のデータ化と解析を行っていると言えます。聞いたことがあるかもしれませんが、人間の音声はたくさんの周波数の組み合わせとその分布から成り立っています。個人によって周波数の範囲は異なるものの、通常だと男性は100~3000ヘルツ、女性は200~6000ヘルツの範囲に収まります。また、相対的に高周波数の領域だと興奮状態、あるいは感情的に覚醒している状態となり、低風波数の領域だとストレス状態となることが多いと言われています。

AIは、コール内の一定時間で高低の周波数がどう変化していくか、そして特定の周波数の発生頻度を分析し、感情を推定しているのです。個人によって特有の高周波と低周波の領域は異なるため、音声解析の中ではその平均値を出して「相対的な変化」を感知することで性別や年齢に依存しない感情解析をしており、この事もディープラーニングによる計算が精度向上に貢献していると言えます。

この音声の周波数の変化や特定周波数の発生頻度が、音声データを一つ一つの変数(=パラメータ)に分類し、その組み合わせを元に、この音声は『怒り』『悲しみ』『喜び』『不安/恐怖』『ストレス』『平常』といった感情に近いと分析されます。

(今回の記事では割愛しますが、コンタクトセンターにおける活用以外にも、犯罪捜査や医療福祉(ストレスチェック)や人事採用の領域で音声認識の活用も進んでいるようです)

音声認識と感情分析の「オペレータ」側にフォーカスしたユースケース

では、このように分析された「感情」はコンタクトセンターではどんなシーンで活用されているのでしょうか?まずオペレータの音声を元にすると「オペレータのストレス・感情判定による教育・フォローへの活用」があります。

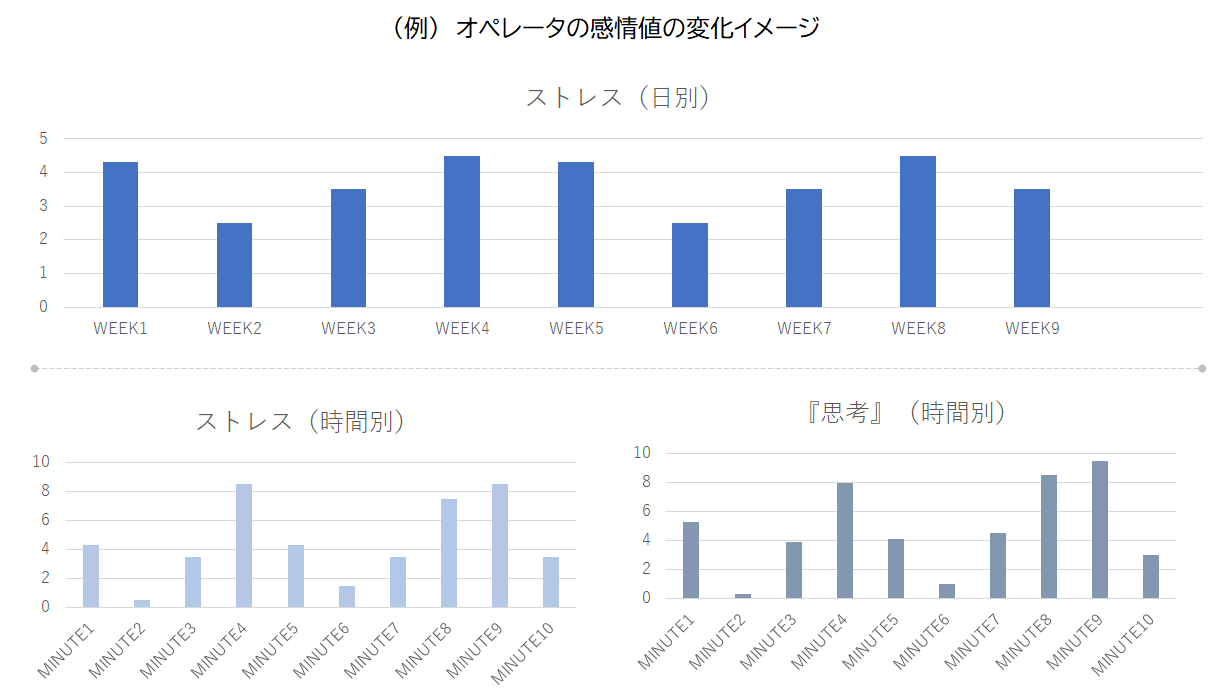

例えば、週次や月次単位でオペレータのストレスレベルを発話音声を元に数値化し、グラフで変化をモニタリングします。すると、特定のコンタクトリーズン(問い合わせの理由)の際に高い『ストレス』の感情反応があったり、「思考」に集中していることを現すデータや、「自信」のなさを現すデータ が出てきたりすることがあります。

これらの結果を元にコンタクトセンター側では、オペレータが特定のコンタクトリーズンに対して持っている知見やトーク力(切り返しなど)の不足によって、試行錯誤をしながら対応をしようとしており、その際に自信のなさからストレスを感じている、という仮説を立てることができます。そして、その原因となっているコンタクトリーズンを苦手分野として、関連する知識を教育・フォローアップしたり、スクリプトを改善したり、ナレッジを充実させたり、配席やエスカレーションの判断軸にしたりという対策を講じることができるのです。

この対策によって業務への自信や実績・成功につながり、早期離職を防ぐことができるでしょう。実際に、個別のトークフローの改善を行うこと以外にも、中期的にストレスレベルの高いオペレータがいた時には「離職傾向が高い」というアラートを感知して、先んじて管理者が面談を行うというフォローの例もあるようです。

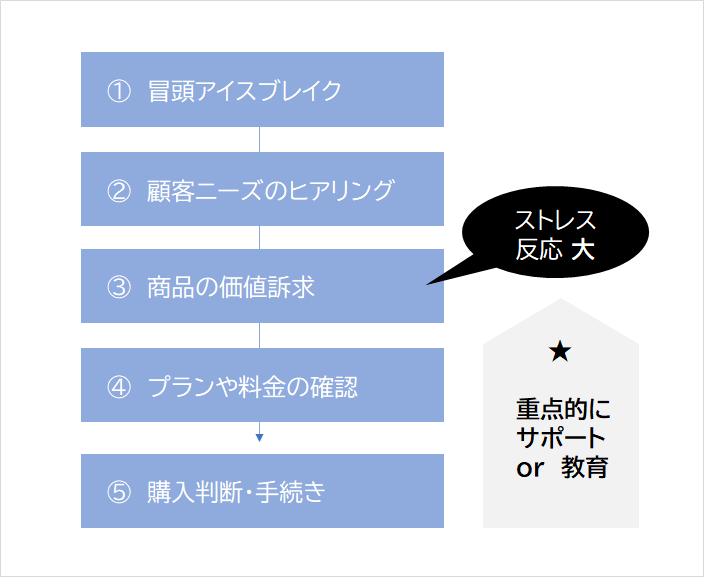

また業務改善だけではなくLTV向上という視点でも、顧客側によい影響を及ぼすことができます。例えば、EC・通信販売で商品を購入するところまでを担うオペレータがいるとしましょう。トークのフローを『①冒頭アイスブレイク』→『②顧客ニーズのヒアリング』→『③商品の価値訴求』→『④プランや料金の確認』→『⑤購入判断』と大きく分けた際に③で上記のようなネガティブなストレス反応が出ていた場合、顧客側にも価値が伝わっていないことになります。その後、③の部分について入念な教育フォローをしたことで、④⑤に進み受注率・成約率が向上した例もあるようです。

(少しそれますが、このような取組はコンタクトセンター業界以外でも「セールスイネーブルメント」の取り組みとしてインサイドセールスやオンライン商談を行うセールスの営業トークの改善に応用され出しているようです)

音声認識と感情分析の「顧客」側にフォーカスしたユースケース

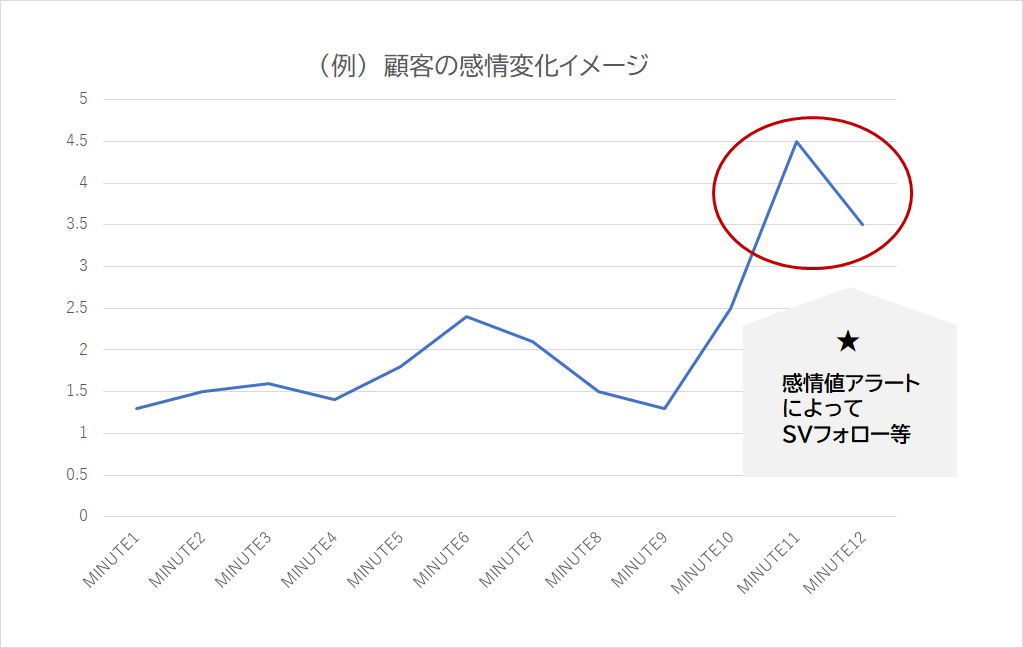

次に顧客の音声に注目してみると「顧客の発話における感情判断によるSVフォローやカスタマーサポートの効率化への活用」があります。

通常SVは担当する卓上のオペレーターの活動をモニタリングしていますが、例えば、通話中の感情が「怒り」「不安」「ストレス」となっている顧客にはいち早くサポートやエスカレーションを促すことができるでしょう。担当するオペレータ数が多い場合、感情分析によってサポート対象が半自動化することはセンターにとっても、顧客側の満足度(これ以上のネガティブ化を回避する)ことにもつながります。

SVがフォローする前の段階でも、発話の内容も含めた音声認識を元に、会話中の課題に関連するナレッジをオペレータに自動表示させるようなシステムも出てきています。そして当然のように、前半で触れたオペレータ側の感情分析と同様に、顧客側の感情分析を根拠にして、オペレータ側のスクリプト改善や教育にも活用がしていけるはずです。

また、通話終了後に顧客の音声を分析し、具体的に言語化はされていないクレーム内容を可視化し製品や顧客対応の改善につなげる事もできます。例えば、SaaS製品を例に挙げると「Aという機能が使えない」というクレームがあったとします。しかし実際には「Aという機能が使えない、という事よりもA機能を使わざるを得ない状況」に対する『怒り』『ストレス』の方が大きいかもしれず、このことが分かった場合には機能改修だけではなくカスタマーサポート(あるいはカスタマーサクセス)による顧客側の運用改善に向けたサポートも必要かもしれません。

とはいえ、「顧客側の音声」はオペレータよりは明瞭に発声されるとは限らないと思います。AIによる認識精度が向上してきたとはいえ、まだ100%完璧に音声や感情を特定することはできないため、分析時には音声認識・感情分析の技術と一緒に、センター側の管理者や担当者による分析もまだ必要な状況と言えるでしょう。

音声認識と感情分析、VOC活用の先にあるものは

これ以外にもオペレータ・顧客の双方の発話データを正確な音声認識によってテキスト化することで感情を伴わない音声データ段階でも、履歴入力の効率化など後処理に応用することができます。(

で紹介した)テキストマイニング・要約の技術を用いることで、オペレータがCRMに入力するACW(アフターコールワーク)の時間を省力化したり、聞き洩らしを音声データでカバーすることができるでしょう。なお、モビルスでは音声領域ではないですが、チャット上でのゲスト発言をAIが感情分析し、ルーム全体の感情スコアを算出する感情分析の機能をオペレータチャット上に実装しています。 音声領域だけではなく、テキスト領域においても感情分析は進化を遂げていますが、この点についてはまた別の記事で詳しく触れていきたいと思います。

自社のコンタクトセンターでのVOCの活用の可能性を模索してみよう

今回の記事では、音声認識や感情分析の活用に触れて、オペレータやセンター側での運用改善を整理してきました。そして改めて顧客サポートシーン周辺でのVOC活用の可能性についても触れてみました。顧客対応の改善や効率化のためにVOCを活用することはカスタマーサポート、カスタマーサクセス部門にいらっしゃる方にとってミッション上で気になる可能性を秘めていると思います。自社にはどのようなVOCが眠っているのか、それをどのように収集するチャネルがあるか、自社で活用するためにはどのようなシーンが可能性としてあるか。まずは一度整理してみるのも良いかもしれません。

モビルスでは、チャットサポート導入で実現する顧客満足度の向上と業務効率化についての「EBook」を公開しています。下記より無料でダウンロードできますので、ぜひご覧になってみてください。